農工業廢料變黃金-鋰離子電池循環再生材料

作者

劉峻誠 & 謝必克簡介

劉峻誠,美國洛杉磯加利福尼亞大學(UCLA)電子工程博士,為耐能研發創辦人,亦為清大助理教授,交大與成大客座副教授,也是國際知名學術期刊的技術審稿人。

謝必克,美國洛杉磯加利福尼亞大學(UCLA)博士,為耐能研發副總裁,主要專注於 AI 芯片的系統架構設計、深度學習模型壓縮以及深度學習應用的算法設計等。單位

耐能智慧股份有限公司-

標籤

-

分享文章

基於國際授權條款4.0,您可免費分享此篇文章

邊緣AI對促進各行業的發展具有一定的積極作用。將AI由雲端去中心化、散佈至邊緣將可以解決雲端資訊傳送相關之費用、緩慢以及安全問題。但如何在不犧牲計算性能的前提下減小AI模型的尺寸是實現此作用的關鍵之一。研究解果發現,通過量化,可將每次計算(乘法和累加)的大小減少了近50%,而精度損失不到1%。

AI硬體(晶片)相當於是承載運算能力的機器,可以比喻為一顆腦袋。AI軟體(模型)則是一套能讓腦袋得知任何結論的思考過程(算法)。最後,將數據(任何傳感器所蒐集到的語音、圖像或是數字觀察)輸入於腦袋(晶片)中,經由適當的思考過程(模型)所處理,得之推理結論。AI可以比喻為是一個孩子,被賦予了一顆優秀的腦袋,在某個領域之中受到了良好的邏輯思維訓練,在接觸並且吸收大量的知識之後便得以自主學習,針對此領域得出精確或是具有洞見的結論。

自2016年AI技術快速發展以來,該技術已被應用在各行各業,讓人類社會發展得更加安全、便利以及繁榮,而自動駕駛汽車是其中較為突出的例子。雖然,全自動駕駛汽車已經醞釀了很長時間。事實上,專家預估未來十年市面上的絕大多數車輛仍停留在L0(人工駕駛)、L1(輔助駕駛)和L2(部分自動駕駛)級別;而更高級別的自動駕駛 L3(條件駕駛)、L4(高度自動駕駛)和L5(完全自動駕駛)則涉及到復雜的技術,包含目前雲端AI應用技術,將AI算法布置在雲端,車輛傳感器將收集到的數據發送到雲端進行處理分析,並立即對實時情況做出回應。雲端AI 涉及三個關鍵因素:(1)成本:發送到雲端的數據太多,需要高昂的寬帶成本,使得該技術難以集成;(2)延遲:數據傳輸會產生延遲,對必須在不到一秒內需做出關鍵反應的駕駛技術存在極大的危險;(3)安全性:雲端傳輸使信息暴露於潛在的數據隱私漏洞和黑客攻擊。因此,我們可以通過邊緣AI在邊緣端的部署來解決問題,而無需通過雲端來回收集數據。然而,將AI轉嫁至邊緣也意味著AI相關軟硬體必需得高度的輕量化,在每個體積輕巧且能源拮据的傳感器或是儀器之中部署強大卻不佔空間、不高度耗能的AI。

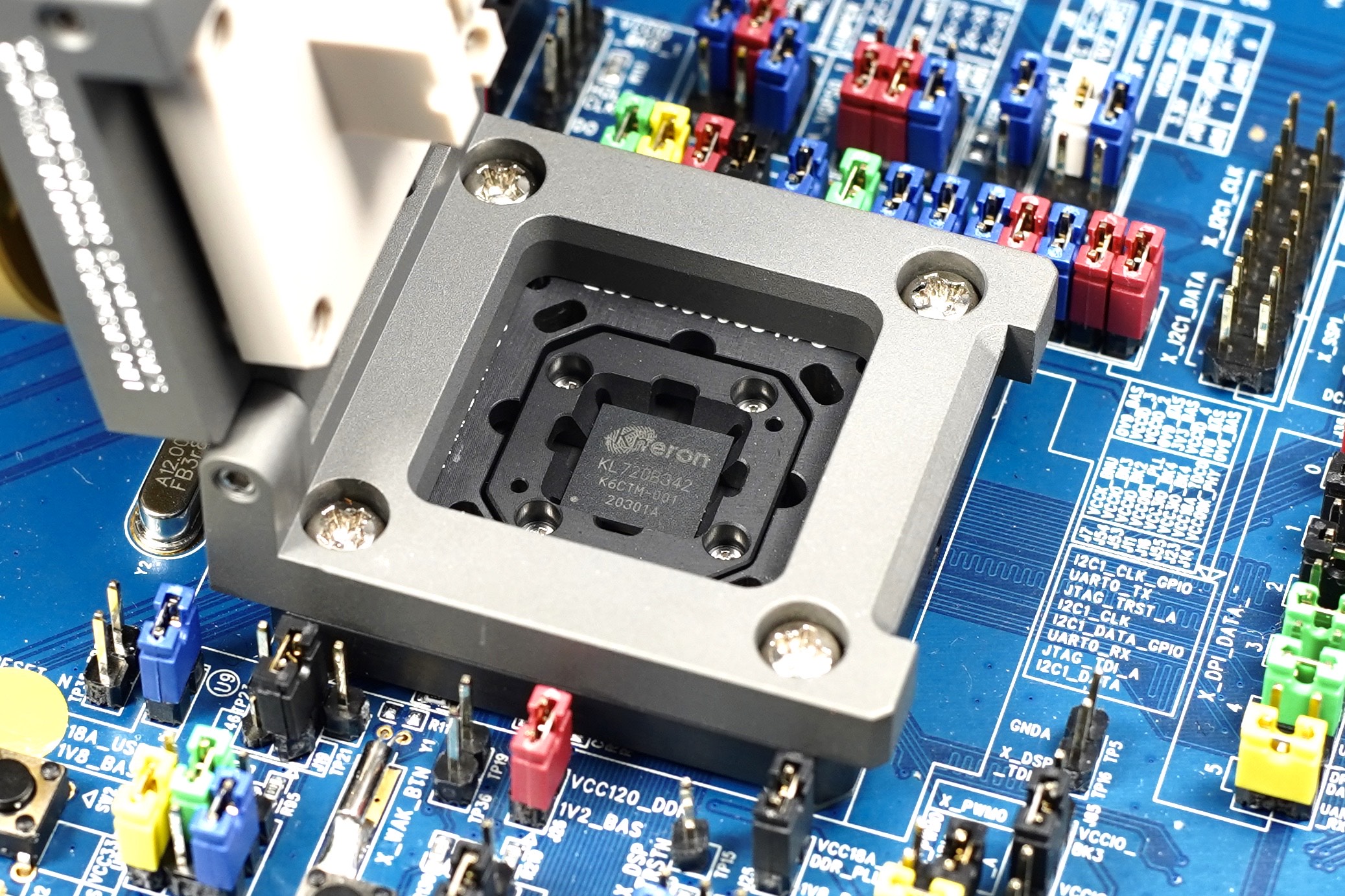

圖一:邊緣 AI 晶片需輕巧、低功耗,利於部署至各種傳感器以及小型的設備中。

本研究團隊專注於模型輕量化的方法,通過剪枝和量化的方法來縮小AI模型的大小。AI 模型的大小相當於權重的數量,藉由AI模型中內置且用於指示如何處理傳入數據(信號),乘以表示權重的位數(也稱為位寬)的特征。

- 剪枝:通過剪枝的方法,對於大多數深度學習模型,我們已經能夠將模型中的權重數量減少50%,從而相應的減小模型大小。

- 量化:雖然用於物體分類和檢測的標準 從32 位浮動模型減少到 8 位模型(INT8)是一種常見的做法,可通過混合INT4-INT8並量化,可進一步將模型的位寬減半。本研究結果發現每次計算(乘法和累加)的大小減少了近 50%,而精度損失小於 1%。

隨著模型大小減半,運行AI模型所需的功耗(瓦特)也隨之減少,通過將AI模型部署到邊緣設備和傳感器上,可有效解決功耗限制的問題且廣泛應用於自動駕駛、智能化基礎設施和智能家居。這種把集中式雲分散到邊緣AI的遷移部署方式可實現更低的成本、快速和安全。

針對減少AI模型的尺寸,工業界和學術界之間仍有很多工作要做。目前有大量關於模型壓縮和量化的學術研究,但大部分研究僅關注卷積神經網絡(CNN)的卷積層,而在很大程度上忽略非卷積層。此外,大部分研究還停留在基本的應用研究,例如分類和檢測。因此,此類研究在幫助工業開發具有代表性的產品時非常有限,部分原因受到每塊晶片的獨特性,研究人員無法解決實際產品中非卷積層面臨的困難(尤其是硬件限制);同時,也無法對每塊晶片進行研究,日後研究非卷積層的負擔則可能落到公司身上。因此,產學合作對未來邊緣AI的發展具有一定的促進作用。將AI硬體以及軟體輕量化使能智慧應用無所不在,觸及體積較小並且能源有限的裝置中,讓車輛、道路周圍以及各種交通相關設施之中的傳感器可以更有效且即時的合作,未來有望迎向安全自動駕駛。

延伸閱讀-科技部(科技大觀園)

訂閱電子報以獲得最新資訊

填寫連絡資訊以取得每月發行之電子報